Forskare vid Cambridge universitet har utvecklat två smartphonebaserade system som bygger på deep learning och påminner om hur autonoma fordon läser av sin omgivning.

De båda systemen är oberoende av GPS och använder sig enbart av visionsensorer (vanliga kameror), precis som vi människor enbart använder ögonen för att hålla koll i trafiken. Detta istället för betydligt dyrare laser- och radarsensorer som de flesta självkörande bilar har idag.

Alex Kendall vid Cambridge universitets Computer Vision & Robotics Group talar om tre huvudtekniker för autonoma fordon, där deras system adresserar de första två:

- Var är jag?

- Vad finns omkring mig?

- Vad ska jag göra härnäst?

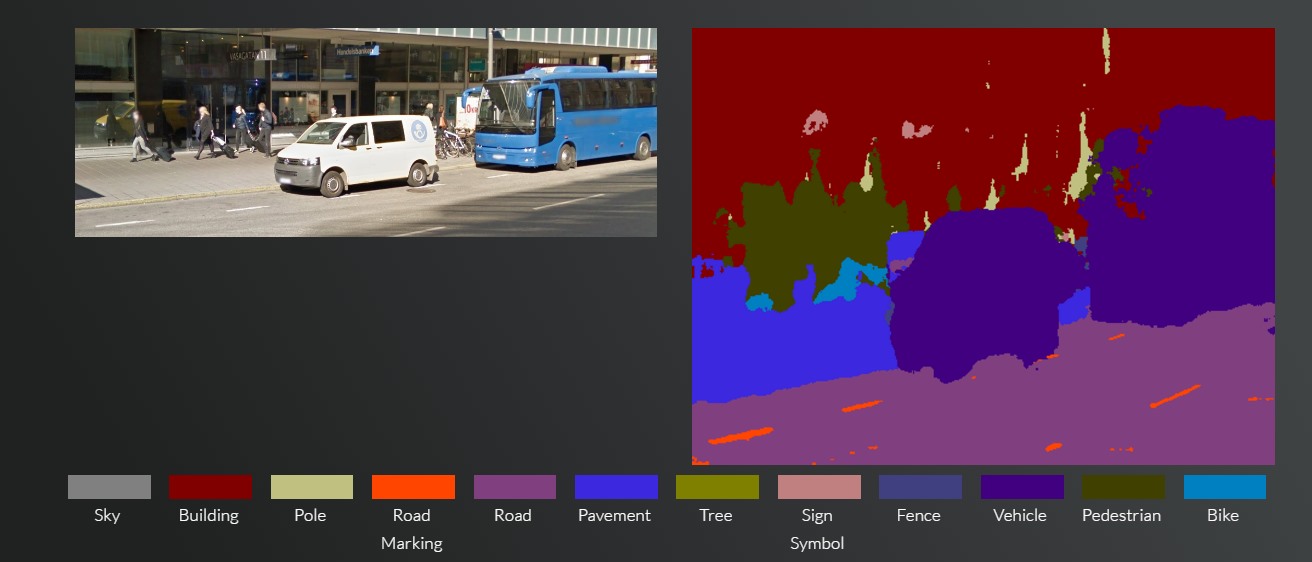

Det ena systemet kallas SegNet och kan ta en (rörlig) bild av en gata i stadsmiljö som det aldrig sett tidigare och klassificera objekten i bilden genom att dela in dem i 12 olika kategorier såsom vägskyltar, cyklister, fotgängare, trottoarer, träd/gräs, stolpar, byggnader med mera. Allt detta sker i realtid och systemet klarar även av olika ljusförhållanden som till exempel skuggor, vilket demonstreras en dryg minut in i videon nedan. Systemet klarar av att klassificera över 90 procent av pixlarna korrekt, vilket uppges vara mer än vad dyra laser- och radarbaserade system klarar av.

SegNet har tränats upp av grupp universitetsstudenter som manuellt har etiketterat varje enskild pixel i 5.000 bilder, där varje bild tagit runt en halvtimma att bearbeta. Efter att alla bilder bearbetats tog det två dagar att träna upp systemet. På webbsidan för SegNet kan man även testa på en demo där man antingen kan ladda upp egna bilder på trafiksituationer eller slumpa fram en bild via Google Maps gatuvy, där bland annat Sverige går att välja, för att se hur systemet klassificerar de olika objekten i bilden.

Det andra systemet, som är tänkt att användas i kombination med SegNet, använder sig istället av geometrin i byggnader, bänkar och liknande i stadsmiljön för att lokalisera var sensorn (mobilkameran i detta fall) befinner sig och ska enligt forskarna ge en mer exakt position än GPS.

På kort sikt är det dock troligare att vi kommer se denna teknik i hemrobotar snarare än självkörande bilar, enligt professor Roberto Cipolla som leder forskningen vid Cambridge.

”På kort sikt är det mer troligt att vi kommer se denna sorts system i en hemrobot – såsom en robotdammsugare”, sa Cipolla. ”Det kommer ta tid innan förare till fullo kan lita på autonoma bilar, men ju mer effektiva och exakta vi kan göra dessa tekniker, desto närmare är vi ett utbrett införande av förarlösa bilar och andra typer av autonom robotik.”

Det skulle kunna innebära att robotdammsugare om några år blir betydligt smartare och via en billig kamerasensor (som många robotdammsugare redan idag är utrustade med) kan känna igen vanliga objekt i ett hem såsom mattor, möbelben och trösklar och därefter anpassa sitt beteende beroende på vilken typ av objekt som kommer i dess väg.